基于注意力机制的图神经网络研究进展

基于注意力机制的图神经网络研究进展

随着深度学习的快速发展,对于基于神经网络的模型可解释性呼声越来越高,而注意力机制可以对模型进行一定程度的解释,在近些年来针对注意力机制的研究也越来愈多。而在另一领域——GNN也得到广泛关注,因此如何将注意力机制集成到GNN上也开始被深入研究,本文浅显的介绍GNN与Attention之间的结合。希望能对大家有所帮助。

1背景介绍

近年来,深度学习在计算机视觉和自然语言处理领域都取得了极大的成功,如机器翻译、目标检测、图像分类等,这些数据表示在欧几里得空间中(又称作欧式数据)。然而,还有很多数据来自于非欧空间,图是一种典型的非欧数据,表示对象及其之间的关系。现实世界中很多事物都可以表示成图数据,如社交网络(微信、微博)、生物网络(分子)、知识图谱(维基百科)、交通网络等。由于其强大的表达能力和复杂性,蕴含丰富的潜在价值。因此,如何利用深度学习方法进行图数据分析吸引了大量研究者关注。将传统深度学习方法应用在图数据有以下挑战:

不规则结构:不同于图像、音频、文本有着明显的格栅结构,图的结构是不规则的,如有多少个节点,每个节点有多少条边都是不确定的。因此很难将一些基本的数学运算推广到图上。

结构和任务多样:有异质图和同质图、带权图和不带权图、有标记图和非标记图之分。另外,图上的任务也非常多,从基于节点的节点分类、链接预测到基于图的图分类、图生成。不用的图结构和任务需要不同的模型来解决相应的问题。

可扩展性和并行化:真实世界中的图通常有数百万以上的节点和边,如社交网络。因此,如何设计一个可扩展且可并行化的模型成为一个重要的问题。

最近已经涌现出许多将深度学习应用到图上的文献,这类方法可以统称为图神经网络(GNNs)根据思想的不同,可以将GNNs分为基于谱的方法和基于空间的方法。

基于谱的方法利用谱图理论[1]将卷积应用到图上。Bruna[2]首先基于谱图理论[1]提出对图拉普拉斯矩阵特征分解来定义图卷积。Defferrard[3]提出使用拉普拉斯矩阵的切比雪夫多项式来近似滤波器。Kipf&Welling[4]仅使用一阶切比雪夫进一步简化滤波器,使其之作用在一阶邻域上。然而,前面提到的所有的谱方法,学习到的滤波器参数都依赖于拉普拉斯特征值分解后的特征向量,也就是说依赖于先验的图结构信息。因此,在一个图上训练的模型不能直接应用到另一个图上因为图的结构变了,不具备归纳(inductive)能力。

基于空间的方法是直接在图上定义卷积,核心是定义一个函数,对节点及其邻居的表示进行操作。但是,由于和图像不同,节点邻居的数目和顺序不是固定的。因此,其中一个挑战就是定义一个能处理不同数量邻居的卷积操作,而且还要保留CNN中权重共享的性质。其中一个工作是Hamilton[5]提出的GraphSAGE,对每个节点采样固定数量的邻居,然后使用一个聚合(平均、最大、LSTM)操作进行聚集得到向量表示。

2 基于注意力机制的GNNs

有一部分研究者将注意力(attention)机制引入到了GNNs中。

注意力机制的本质是从人类视觉注意力机制中获得灵感。大致是我们视觉在感知东西的时候,一般不会是一个场景从到头看到尾全部都看,而是根据需求观察特定的一部分。这意味着,当人们注意到某个目标或某个场景时,该目标内部以及该场景内每一处空间位置上的注意力分布是不一样的。而且当我们发现一个场景经常在某部分出现自己想观察的东西时,我们就会进行学习在将来再出现类似场景时把注意力放到该部分上。更通用的解释就是,注意力机制是根据当前的某个状态,从已有的大量信息中选择性的关注部分信息的方法,其实就是一系列注意力分配系数。

基于注意力机制的GNNs的思想是在计算每个节点的表示的时候,首先计算和邻居节点之间的注意力系数,为重要的邻居节点分配较大的权重,在卷积的过程中将不同的重要性分配给邻域内不同的节点。

3 模型

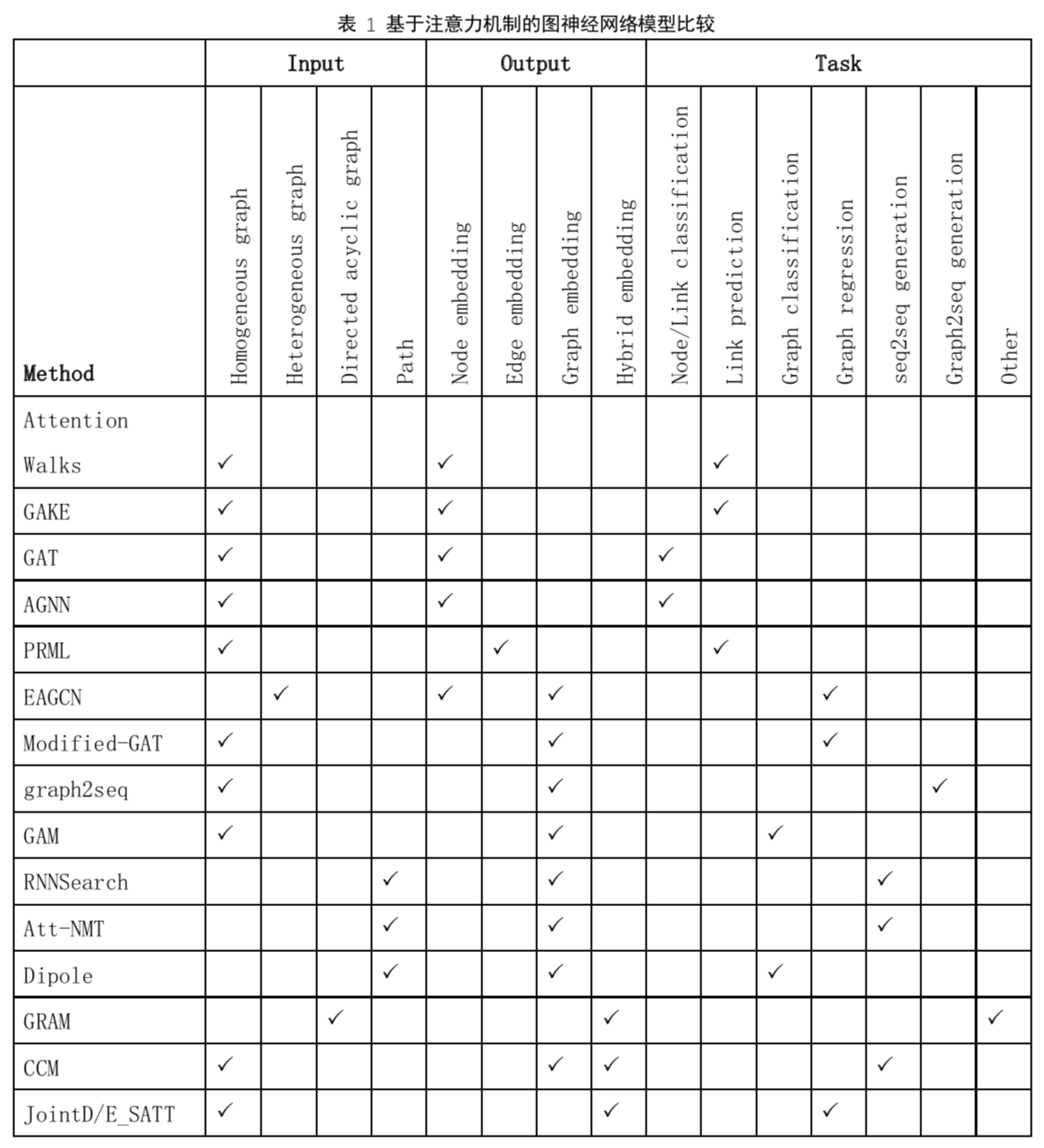

为了方便从宏观角度对模型有整体的认识,表1按照输入、输出、任务对近两年发表的基于注意力机制的图神经网络模型进行汇总比较。

详细报告请参见附件!