CSIG参会报告

CSIG参会报告

当前机器学习技术收到广泛的应用,在1月16日由中国图形学会和北京大学机器感知与智能重点实验室联合举办的CSIG大会上,众多大牛对机器学习相关问题进行了探讨,我针对个人比较喜欢的几个报告进行了相应的记录,希望对各位对机器学习同样有兴趣的人一个参考,如有错误,欢迎指正。

报告一:Deep Learning: From Theory to Algorithm

报告嘉宾:王立威(背景大学)

该报告主要从理论或是机器学习“特征“的角度来看待机器学习,这些工作期望能够理解 deep leaning的机理,从而支持一些有一定理论的深度学习算法的发现。我个人认为这些理论能够让我们在使用机器学习是能过够促进模型架构的合理设计,因而进行详细的记录。

王老师首先介绍了deep learning与传统的机器学习的不同:over-parametrization:deep learning的参数往往超过其训练数据的量。

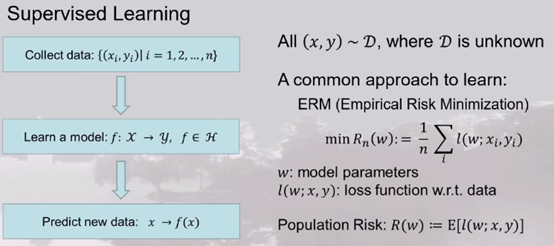

之后,介绍了理论研究的前提结构:监督学习:

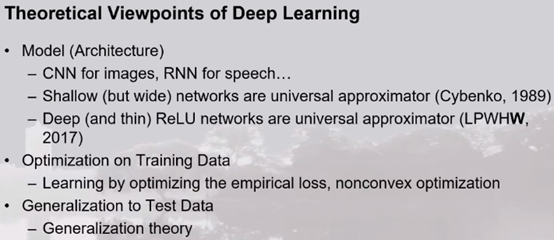

然后,提出了三个重要的理论研究点:

其中,第一点主要研究模型的拟合能力,第二点是理解deep learning optimization 的原理,点三点为模型泛化能力的理解。

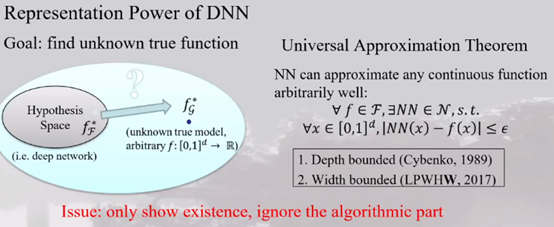

第一点

李老师介绍了deep learning的逼近能力:

1. 对于有限函数,单层足够宽的神经网络能够按照任意精度逼近。

2. 对于当前 deep learning 的情况,任意可积函数,在网络宽度大于input维度的情况下,神经网络通过增加深度能够以任意精度逼近该函数。

第二点

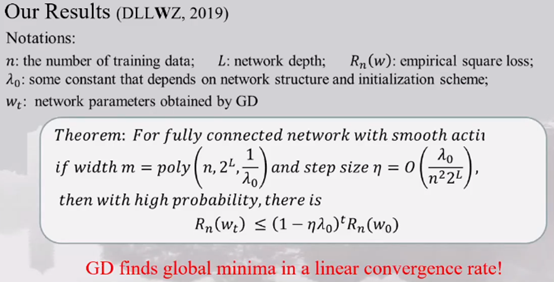

对于deep learning 能够找到一个全局最优化的现象给出了一个解释:在网络需要足够的过参数化且合理参数初始化条件下,deep learning能够找到全局最优点:

在该结果下,神经网络有两个重要的inside:

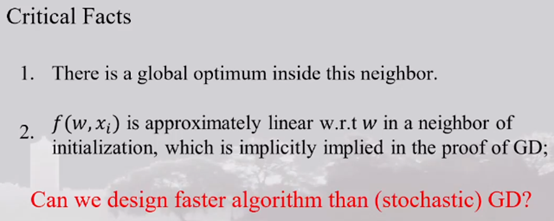

另外,李老师还给出了他人一项重要研究的结果:在网络无限宽的情况下,神经网络就退化成为了一个kernel machine:

第三点

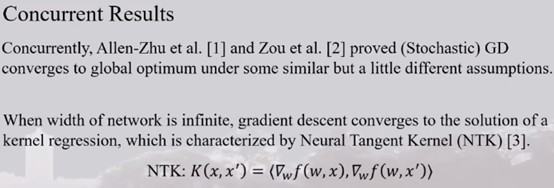

传统机器学习的泛化能力由于deep learning 的over-parametrization的条件,其泛化理论毫无意义:

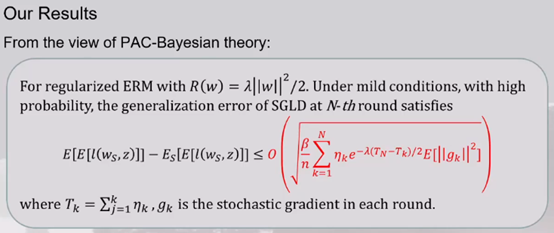

李老师的工作中给出了一个泛化能力的结论:deep learning泛化能力不仅与模型大小有关,还与模型的优化算法有关,从而得到了下面的返还能力的结果。该结果符合一个现象:当训练时达到一个flat minima时,有一个比较好的泛化,否则,泛化能力不佳。

报告二:Adversarial Machine Learning and Beyond

报告人:王奕森

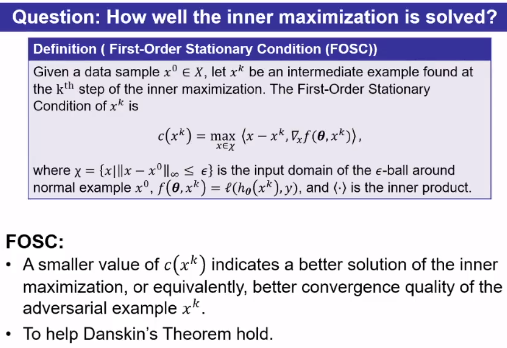

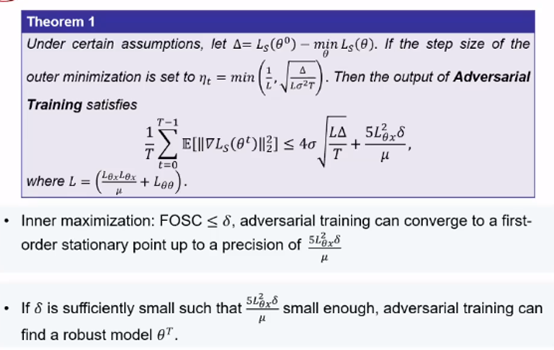

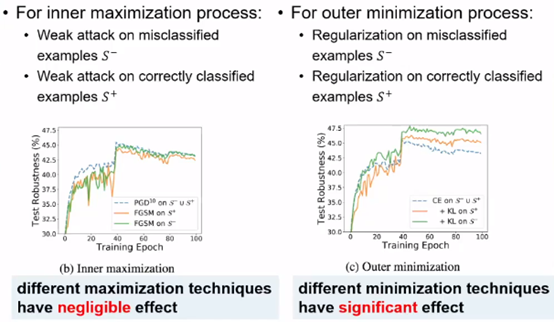

本次报告主要介绍了王老师在对抗训练上进行的三个工作:一是寻找对抗训练中内部maximization的最优解应该是什么样的,二是找到一个更加泛化的内部最优maximization,第三个是优化外部的minimization。

最优maximization

李老师证明了内部最优maximization为如下形式:

之后,通过对上述条件进行放缩后,可以使得内部最大化得到一个较好的近似:

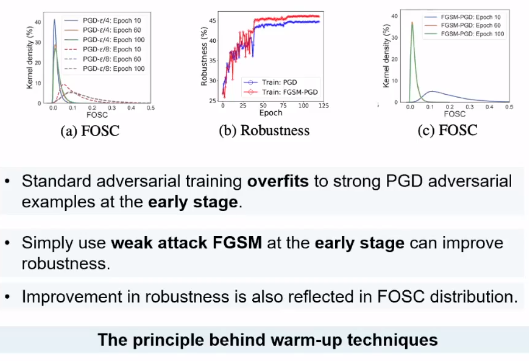

最终,通过该理论证明了在对抗训练时仅仅使用FGSM攻击和early stage即可得到很好训练效果。

对于第二点我已经在之前的参会笔记中已经给出,不再介绍。

优化外部minimization

其主要思想来自与对于已经分错的情况下,外部minimization收到该样本影响严重:

基于此,提出了对内部的优化方法: